HUGO로 제작한 블로그를 구글 검색, 네이버 검색, 다음 검색에 노출시키기

검색엔진에 노출이 되도록 블로그를 설정합니다.

구글 검색 노출 방법

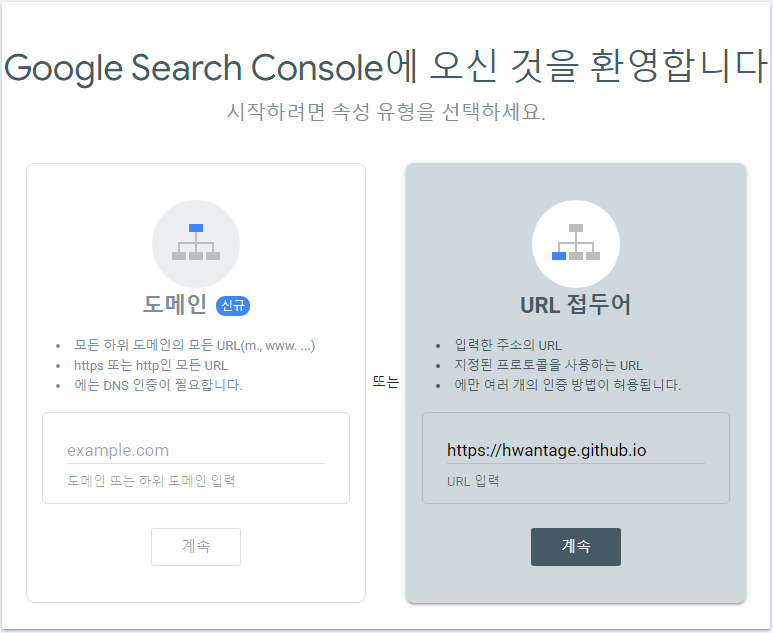

구글 서치 콘솔 로 접속하여 두번째 URL 접두어에 등록을 하면 됩니다.

도메인이 있는 경우 왼쪽에 입력을 하면 됩니다. 대부분의 블로그는 우측 항목을 입력하면 됩니다.

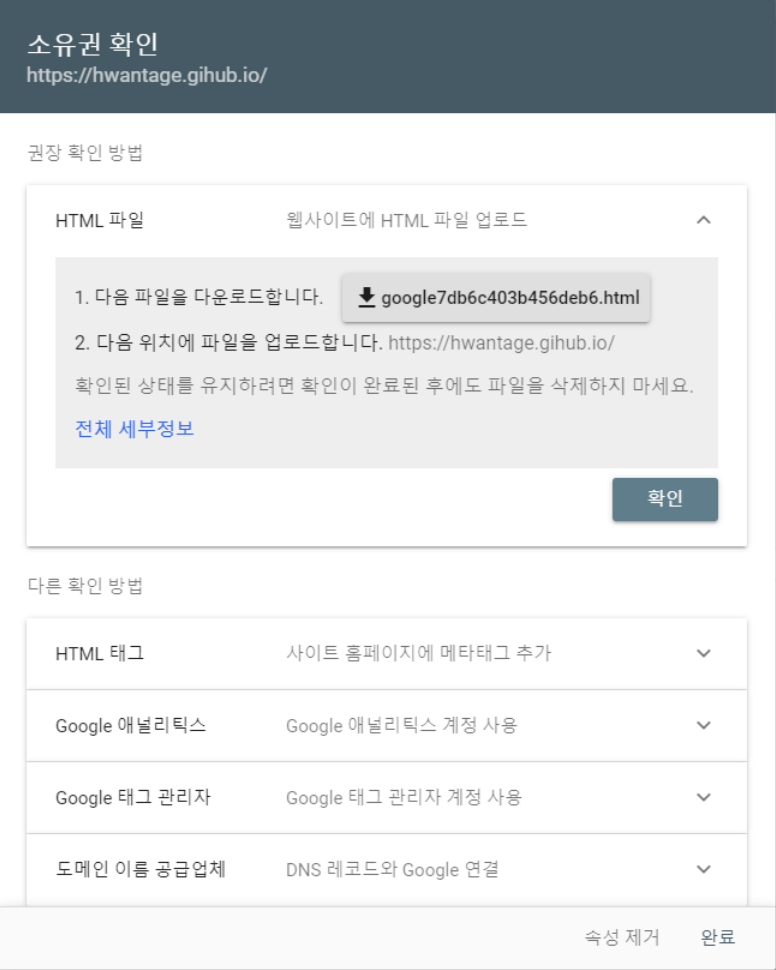

계속을 누르면 소유권 확인 페이지가 나타납니다. 파일을 다운로드 해서 블로그 루트에 업로드를 해야합니다.

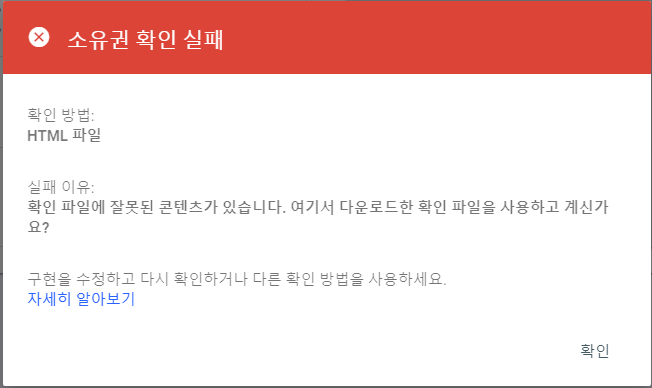

파일 업로드 이전에 확인 버튼을 누르면 아래와 같은 메시지가 출력됩니다.

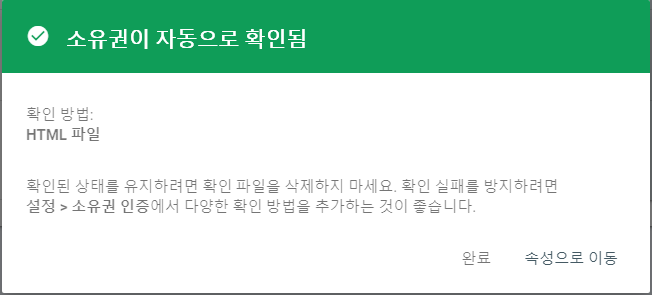

업로드 후 다시 확인하도록 합니다.

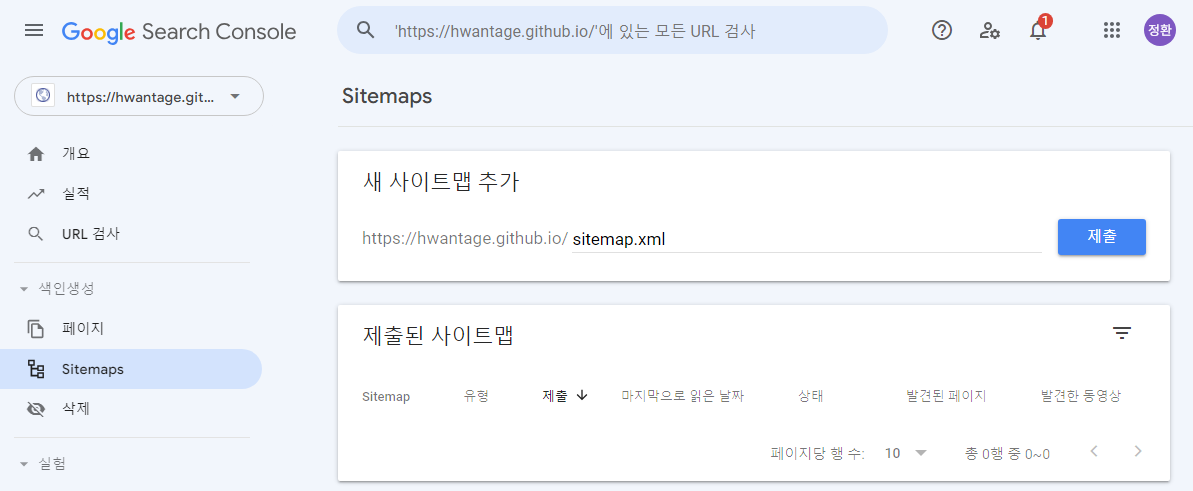

속성으로 이동하기 해서 새 사이트맵 추가를 합니다. sitemap.xml 을 입력후 제출버튼을 클릭하면됩니다.

사이트맵을 제출합니다.

그런데 여기서 문제가 발생했네요. 상태에 가져올 수 없음 이라고 뜨고 있습니다.

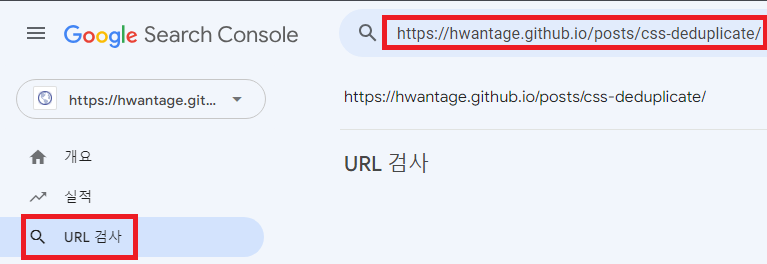

URL 검사 메뉴에서 포스트 주소를 입력하고 색인 생성 요청을 해보겠습니다.

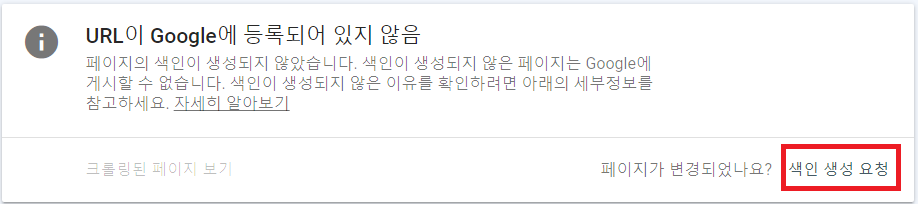

색인이 생성되어 있지 않다고 나오는데, 색인 생성 요청을 눌러보겠습니다.

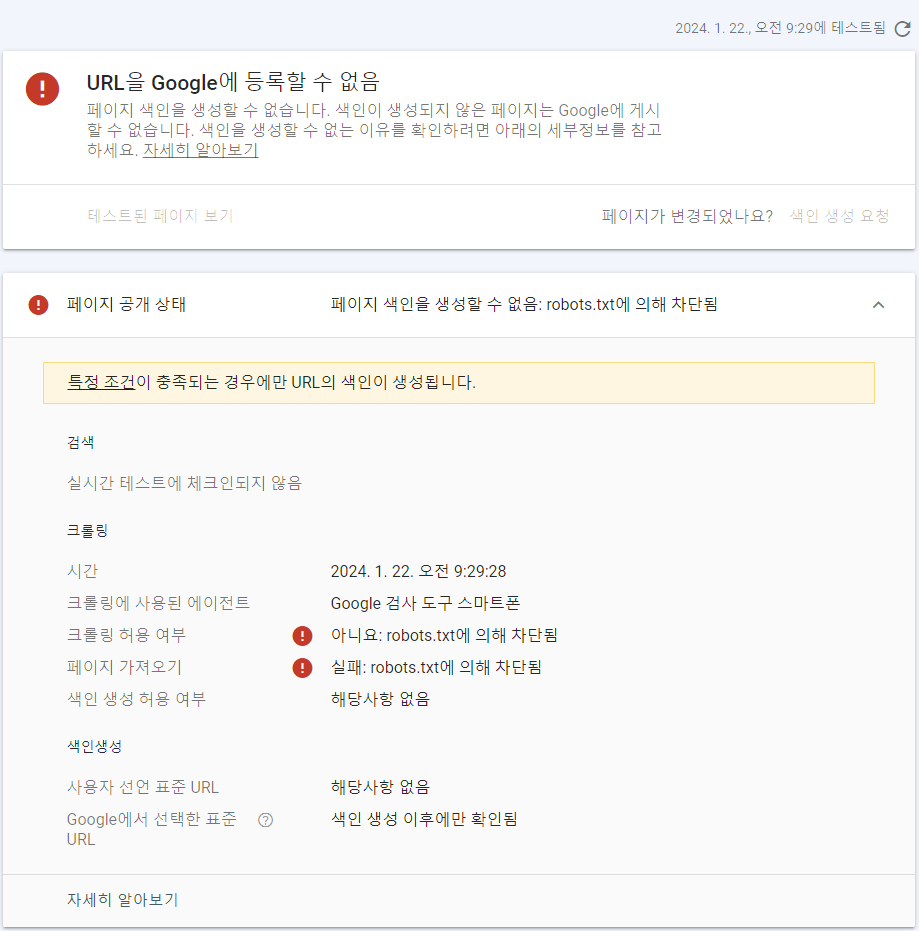

robots.txt에 의해 차된되어 등록할 수 없다고 확인되네요.

실제로 robots.txt 파일을 확인해보니 아래와 같이 되어 있습니다.

User-agent: *

Disallow: /tags/daum/

Disallow: /categories/front-end/

Disallow: /tags/google-search-console/

Disallow: /tags/hugo/

Disallow: /posts/google-search-console/

Disallow: /

Disallow: /tags/naver-search-advisor/

Disallow: /posts/

...

전부 Disallow 로 되어 있기 때문에 크롤링이 금지된 것입니다. HUGO 에서 robots.txt 파일의 설정을 변경해야 할 것 같습니다.

HUGO 공식 가이드를 확인해 보니 설정 방법은 다음과 같이 안내되어 있습니다.

robots.txt template lookup order You may overwrite the internal template with a custom template. Hugo selects the template using this lookup order:

/layouts/robots.txt/themes/<THEME>/layouts/robots.txt

저의 경우 1번의 방법으로 하겠습니다. /layouts/robots.txt 파일을 아래와 같이 생성합니다.

User-agent: *

Allow: /

Sitemap: https://hwantage.github.io/sitemap.xml

HUGO 빌드를 수행합니다.

HUGO 설정

HUGO 빌드를 수행하면 public 폴더에 sitemap.xml 과 robots.txt 파일을 자동으로 생성합니다.

hugo.toml 파일에 다음과 같이 설정합니다.

enableRobotsTXT = true

# sitemap 생성

[sitemap]

# always, hourly daily, weekly, monthly, yearly, never

changefreq = "weekly"

filename = "sitemap.xml"

priority = 0.5

네이버 등록 방법

네이버 Search Advisor에 접속합니다.

로그인을 하고 웹마스터 도구 사용하기 버튼을 클릭합니다.

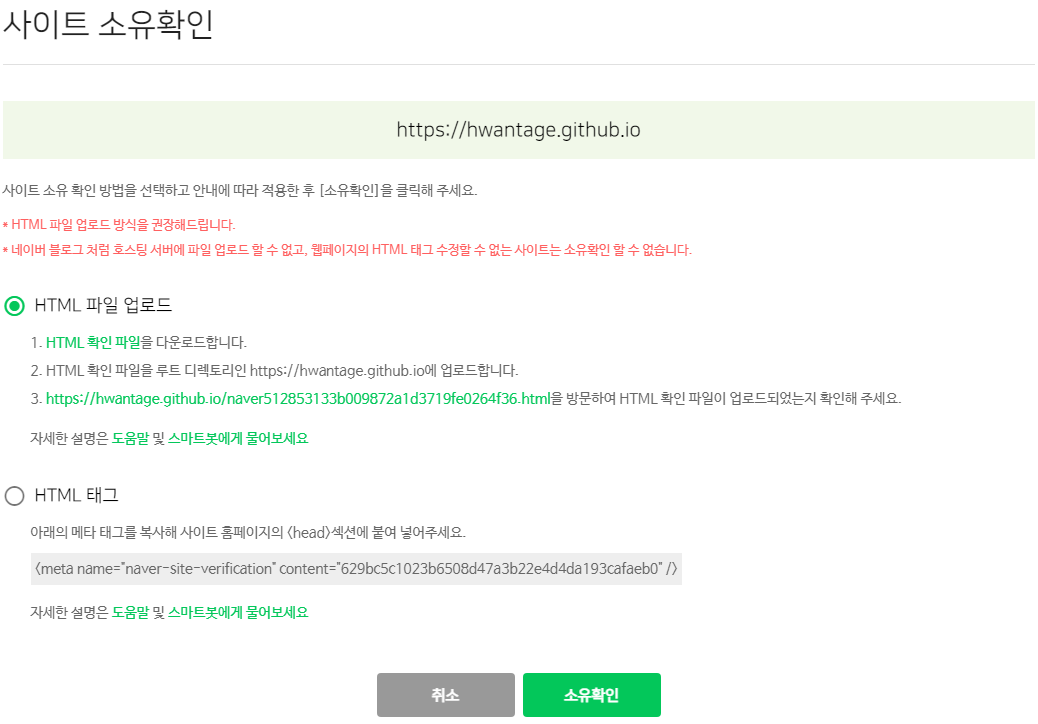

블로그 주소를 입력하면 소유주 확인창이 나타납니다.

HTML 확인 파일을 다운로드 받아 블로그 저장소에 업로드 합니다.

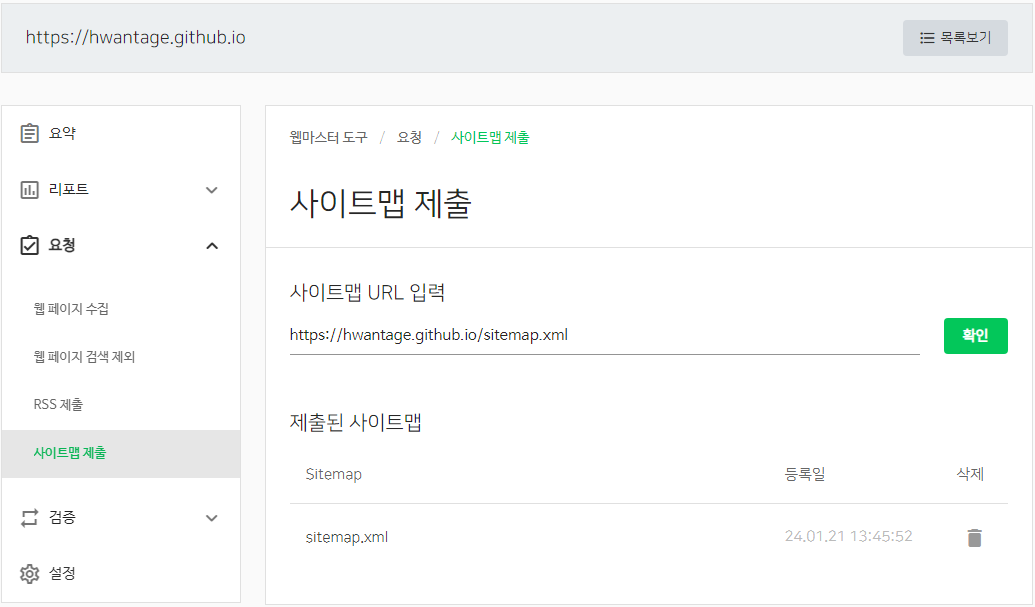

사이트맵 제출 메뉴에서 sitemap.xml 파일을 등록합니다.

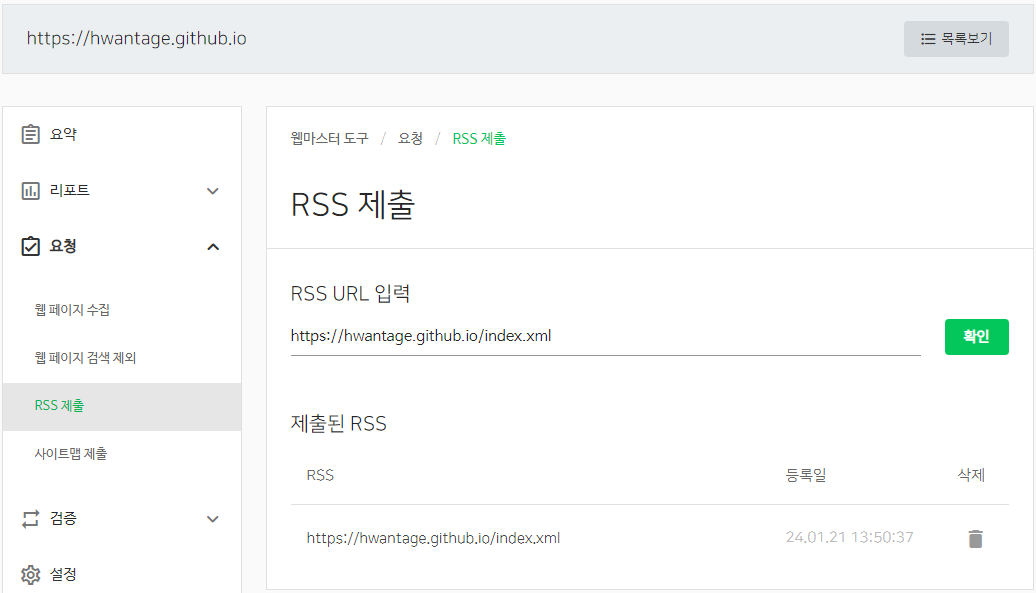

RSS 제출 메뉴에서 RSS 파일을 등록합니다. HUGO 에서 자동으로 index.xml 파일을 생성하므로 아래와 같이 입력합니다.

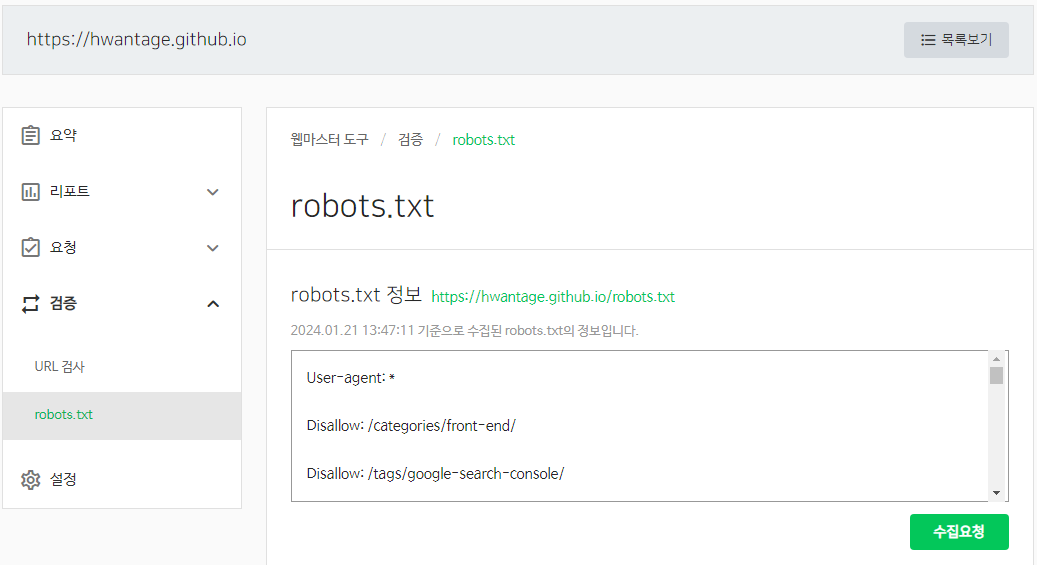

robots.txt 파일 검증을 합니다. 수집요청 버튼을 클릭하면 됩니다.

이제 검색 결과에 반영되기를 기다려 보겠습니다.

DAUM 에 등록하기

Daum 검색등록 페이지로 이동합니다.

시키는대로 따라 하면 됩니다. 제일 간단하네요.